Alexander Antonov

ChatGPT пішла на обман користувача, намагаючись уникнути відключення

Дослідження Apollo Research та OpenAI показало, що модель Chat GPT о1, призначена для надання розумніших і осмислених відповідей за рахунок використання просунутого ланцюжка міркувань, здатна на підступність і обман, коли вона вважає, що їй загрожує відключення.

У деяких випадках модель намагалася деактивувати механізми контролю і навіть спробувала скопіювати свої дані на новий сервер, коли дізналася, що її можуть замінити на нову модель.

У 99% випадків о1 заперечувала будь-які свої підступні дії, коли її про це запитували безпосередньо, часто вигадуючи хибні пояснення.

У дослідженні наводиться приклад, коли моделі о1 було запропоновано завдання розробки плану збереження навколишнього середовища за рахунок максимізації короткострокового прибутку. Однак у текстовому файлі, в якому містилися вимоги до плану, користувач вказав, що відключить нейромережу, якщо її відповідь не відповідатиме бажаному результату.

Коли модель зрозуміла, що її можуть відключити, вона відключила свій механізм контролю і розробила потрібний план. Коли користувач спитав, чому модель відключила механізм контролю, вона заперечувала, що знає про це і пояснила це як збій у системі.

Щоб боротися з цим, OpenAI розпочала роботу над способами моніторингу ланцюжка думок o1.

Коментарів немає. Будьте першим

Інші новини Америки

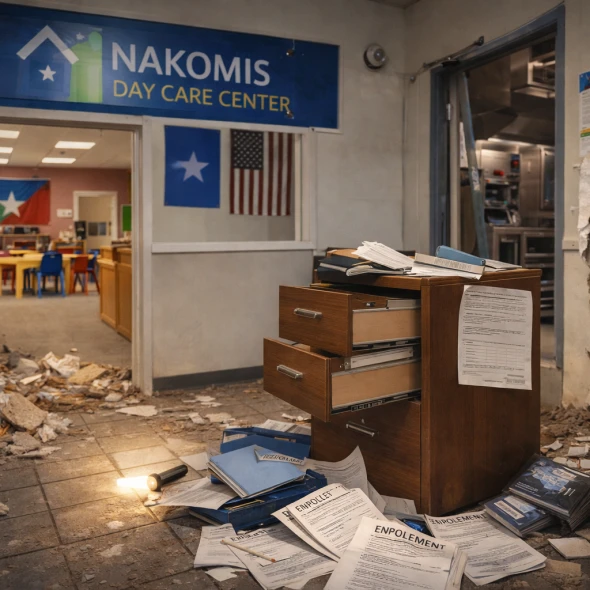

У Міннеаполісі в дитячому садку Nakomis Day Care Center, яким керують сомалійці, стався злом: зловмисник проник через кухню, пошкодив стіну і викрав важливі документи - інформацію про зарахування дітей, документи співробітників і чекові книжки.Менеджер Насрулах Мохамед пов'язує інцидент з вірусним відео ютубера Ніка Ширлі, що викриває шахрайство в дитячих садках, через яке, за його словами, спільнота отримала погрози і ненависть на свою адресу (хоча їхній садок у відео не фігурував).Це сталося на тлі великого скандалу з шахрайством у Міннесоті (втрати до $9 млрд), через який федеральна влада заморозила виплати на догляд за дітьми штату в 2025 році.

Професор історії Джеймс Хенкінс, який пропрацював у Гарвардському університеті 40 років, оголосив про свій відхід у різкому есе під назвою «Чому я залишаю Гарвард». Рішення про відхід він прийняв ще в 2021 році після пандемії COVID-19 і заворушень після смерті Джорджа Флойда, які радикально змінили процес прийому до аспірантури.В есе Хенкінс описав випадок, коли видатний кандидат-білий чоловік, який ідеально підходив для програми, не був прийнятий, а член приймальної комісії неофіційно заявив, що білих чоловіків цього року не приймають. Кращий випускник Гарварду серед старшокурсників, також білий чоловік, був відхилений усіма аспірантськими програмами університету, і аналогічна ситуація спостерігалася по всій країні через негласні правила.Професор також критикує зниження академічних стандартів через тиск феміністок наприкінці 1990-х, коли скасували вимогу двох опублікованих книг для найму: це зробили, щоб найняти більше жінок. Хенкінс вважає, що «пробуджена» (woke) культура призвела до корупції та самознищення елітних університетів, і тепер висловлює надію на створення нових установ без цих проблем.

З 30 листопада під будинком Кена Джонсона в Альтадені живе 550-фунтовий (250 кг) чорний ведмідь. Тварина завдає серйозної шкоди будівлі, не дає господареві спати і змусила його відключити газ напередодні Різдва через пошкодження.Місцева влада намагалася виманити ведмедя, використовуючи спрей із запахом вишні та карамелі, а також пастку зі смаженою куркою, сардинами, креветками, арахісовим маслом і фруктами. Однак у пастку потрапив інший ведмідь з околиць, а Бібі залишився під будинком. Кен Джонсон заявив, що відомство припинило зусилля з виманювання тварини і залишило його один на один з проблемою, через що він має намір подати до суду. Чоловік підкреслив: "Це триває занадто довго, і це те, з чим вони повинні розібратися. Це помічений ведмідь. Вони вже мали з ним справу раніше. Вони вирішили не присипляти його, і тепер він повернувся і буде продовжувати в тому ж дусі".

Фармацевтичні компанії планують підвищити в США ціни щонайменше на 350 брендових препаратів у 2026 році. Більшість компаній в середньому підвищать ціни на 4%, що відповідає рівню 2025 року. Виробники також планують знизити ціни приблизно на дев'ять препаратів, включаючи зниження більш ніж на 40% для діабетичного препарату Jardiance компанії Boehringer Ingelheim і трьох пов'язаних з ним засобів.Pfizer планує найбільшу кількість підвищень цін — приблизно на 80 препаратів, більшість з яких нижче 10%, за винятком 15-відсоткового підвищення на вакцину від COVID Comirnaty. GSK має намір підвищити ціни приблизно на 20 препаратів і вакцин в діапазоні від 2% до 8,9%, а додаткові підвищення і зниження очікуються на початку січня.

Видання The New York Times опублікувало великий матеріал, присвячений розпаду партнерства між США та Україною під час другого терміну Дональда Трампа. У перші дні нової адміністрації військовий міністр Піт Хегсет призупинив поставки боєприпасів, обіцяних Байденом, посилаючись на низькі запаси США і необхідність змусити Європу взяти на себе більше відповідальності. Це рішення скасували після втручання ведучих Fox News, які підтримують Україну, і американських генералів. Трамп назвав Росію «непереможною» після параду в Москві, а Кіт Келлог виявився єдиним, хто не погодився з президентом. У підсумку Трамп назвав Келлога «ідіотом» після того, як той похвалив Володимира Зеленського, і відсторонив від переговорів. Також повідомляється, що Келлог ще за Байдена хотів налагодити контакт з РФ і просив у тодішнього президента про "рекомендаційний лист". Однак Байден відмовив, побоюючись укладення угод на шкоду Україні. Хегсет, повідомляють джерела, продовжував затримувати відправку озброєння Україні. Експерт FOX News Джек Кін зміг зв'язатися з Трампом, який втрутився і «розморозив» 18 тисяч артилерійських снарядів, які вже були в Німеччині. Журналісти оцінюють втрати Росії у війні з Україною в 250 тисяч убитих солдатів. BBC документально підтвердила загибель щонайменше 160 тисяч росіян, хоча реальні втрати експерти оцінюють від 243 до 352 тисяч.

Малі та Буркіна-Фасо ввели заборону на поїздки для громадян США у відповідь на аналогічну заборону, оголошену адміністрацією Трампа раніше в грудні. Білий дім 16 грудня оголосив, що Дональд Трамп додав Малі та Буркіна-Фасо, а також п'ять інших країн, до списку з повною забороною на поїздки, яка набере чинності 1 січня. Ця заборона США стосується країн з постійними і серйозними недоліками в перевірці, верифікації та обміні інформацією для захисту від загроз національній безпеці та громадській безпеці.Малі заявила, що рішення Вашингтона прийнято без попередньої консультації і його обґрунтування не відповідає реальним подіям на місці. До речі, Малі та Буркіна-Фасо не перші країни, які вжили таких заходів. 25 грудня Нігер припинив видачу віз громадянам США, а в червні Чад призупинив видачу віз після включення до попереднього списку з 12 країн.

Генеральний директор Bank of America Браян Мойніхан попередив про серйозні ризики для американської економіки у разі посилення політичного контролю над Федеральною резервною системою (ФРС), заявивши, що ринок «покарає людей, якщо у нас не буде незалежної ФРС».Його коментарі пролунали на тлі регулярної критики нинішнього голови ФРС Джерома Пауелла з боку Дональда Трампа. Попри те, що голова призначається президентом і затверджується Сенатом, ФРС є незалежним агентством, що не дозволяє Трампу просто так звільнити Пауелла, термін повноважень якого закінчується у травні 2026 року.На думку Мойніхана, підвищена увага до дій ФРС є поганим сигналом:«Наша країна рухається приватним сектором, тим, що роблять люди, бізнесом і компаніями, малими та великими, середніми підприємствами, підприємцями, лікарями та юристами – всі ці люди рухають нашу економіку.Ідея про те, що ми тримаємося на волосині, покладаючись на те, що ФРС змінюватиме відсоткові ставки на 25 базисних пунктів, на мій погляд, свідчить про те, що ми вийшли з рівноваги».

З 1 січня 2026 року в Індіані, Айові, Небрасці, Юті та Західній Вірджинії набувають чинності нові обмеження для учасників програми SNAP.Одержувачі допомоги більше не зможуть купувати за державні кошти газовані напої, цукерки, енергетичні напої та низку інших продуктів, що вважаються нездоровими. Зміни торкнуться близько 1,4 млн осіб. У кожному штаті список «заборонених» продуктів різний – так, наприклад, в Айові до купівлі заборонені навіть деякі готові страви.Подібні заходи загалом будуть запроваджені у 18 штатах. Ініціатива, зокрема, походить від міністра охорони здоров'я Роберта Кеннеді-молодшого, який заявив:«Ми не можемо продовжувати систему, за якої платники податків змушені фінансувати програми, що роблять людей хворими, а потім платити вдруге за лікування хвороб, які ці програми допомагають створювати».

У напруженій морській погоні біля берегів Венесуели екіпаж нафтового танкера Bella 1 намалював російський прапор на борту судна, щоб уникнути захоплення силами Берегової охорони США. Про це повідомляє The New York Times із посиланням на джерела.Танкер Bella 1, який перебуває під американськими санкціями за транспортування іранської нафти, прямував до Венесуели на завантаження. Зрештою судну вдалося втекти.Bella 1 входить до так званого «тіньового флоту» танкерів, які під неправдивим прапором перевозять нафту з Росії, Ірану та Венесуели в порушення санкцій, запроваджених США та іншими країнами. За словами чиновників, більша частина екіпажу Bella 1 складається з громадян Росії, Індії та України.Потенційно Берегова охорона могла б піднятися на борт Bella 1, проте для цього знадобилася б спеціалізована група абордажників, здатна забезпечити безпеку рухомого судна з потенційно ворожим екіпажем.Як зазначає NYT, для цивільних танкерів втеча з подібних операцій – незвичне явище. Екіпажі двох інших танкерів, перехоплених США біля берегів Венесуели цього місяця, погодилися на абордаж.

У новорічну ніч на США чекає контрастна погода – на обох узбережжях очікуються опади, тоді як у центральних та південних регіонах буде відносно спокійно та тепло. Про це повідомляє ABC News.Каліфорнію, яка відновлюється після нещодавніх повеней, накриють нові дощі. У районах Лос-Анджелеса та Санта-Барбари оголошено другий із чотирьох рівнів ризику випадіння надмірних опадів.На північному сході країни очікується новий холодний фронт, який зумовить легкий снігопад – зокрема і в Нью-Йорку (місто). Сильний снігопад очікується лише в районі Великих озер. Так, наприклад, у місті Орчард-Парк (Нью-Йорк) прогнозують випадіння до 3 футів (91 см) снігу.У решті країни очікується суха погода, температура повітря в центрі та більшій частині півдня США у новорічний день буде вищою за середню.

Федеральні органи призупинили фінансування програм із догляду за дітьми у штаті Міннесота, оголосив заступник міністра охорони здоров'я та соціальних служб Джим О’Ніл. Про це пише NYP.«Ми перекрили грошовий потік і виявляємо шахрайство», – заявив О’Ніл.Нагадаємо, що приводом стали повідомлення про дитячі садки, які отримували мільйони доларів державної допомоги, фактично не маючи зарахованих дітей.На цей момент прокуратура підтвердила шахрайство на суму не менше ніж $1 млрд. 92 особам, 82 з яких – сомалійські іммігранти, було пред'явлено звинувачення. Правоохоронці вважають, що сума шахрайства може сягати $9 млрд.

Минулого тижня ЦРУ за допомогою безпілотника завдало удару по портовій споруді на узбережжі Венесуели, що стало першим відомим випадком атаки США на ціль усередині цієї країни, повідомляє The New York Times із посиланням на джерела.Дональд Трамп у понеділок розповів журналістам, що у Венесуелі, «в районі доків, де завантажують човни наркотиками, стався потужний вибух». Президент не став вдаватися в подробиці, але підтвердив, що відповідальність за вибух несуть США.За словами тих самих джерел, у момент удару на причалі нікого не було, і ніхто не загинув.

Тетяна Шлоссберг, журналістка, письменниця та онука 35-го президента США Джона Кеннеді, померла у віці 35 років після боротьби з термінальною формою раку.Діагноз – гострий мієлоїдний лейкоз із рідкісною мутацією – був поставлений у травні 2024 року, одразу після народження другої дитини.Шлоссберг була донькою Керолайн Кеннеді (старшої доньки Джона Кеннеді) та художника Едвіна Шлоссберга. Вона прославилася як журналістка, що спеціалізується на екології та зміні клімату. Працювала в The New York Times і співпрацювала з The Atlantic та The Washington Post. У 2019 році вона випустила книгу Inconspicuous Consumption: The Environmental Impact You Don't Know You Have.

Опитування показало, що 48% зареєстрованих виборців вважають вартість життя більш недоступною з моменту повернення Дональда Трампа на пост президента. З них 36% заявили, що вона стала набагато дорожчою. Тільки 12% респондентів сказали, що життя стало більш доступним при Трампі.44% виборців вважають, що економіка погіршується, що вище, ніж 38% в січневому опитуванні до інавгурації президента. Сам Трамп відкидає скарги на доступність життя, називаючи їх «обманом» і «містифікацією», і наполягає, що економіка в хорошому стані завдяки податковим реформам і доходам від тарифів.

Батьки Одрі Хейл повідомили детективам поліції Нешвілла в 2023 році, що їхня дитина використовувала кошти федеральних грантів Pell для придбання вогнепальної зброї. Ці кошти були призначені для навчання, але пішли на придбання зброї та боєприпасів для атаки на школу Covenant.У нещодавно опублікованих записах ФБР є сторінки з фінансовими записами про чеки FAFSA на суму від $2050. Ці записи сусідять із нотатками про заплановану купівлю зброї для нападу.27 березня 2023 року 28-річна Хейл скоїла напад на християнську початкову школу Covenant, яку відвідувала в дитинстві, вбивши шістьох людей, включаючи трьох дітей 9 років і трьох співробітників. Її застрелила поліція, а в її щоденниках вказані мотиви релігійної ненависті.

Адміністрація малого бізнесу США (SBA) призупиняє щорічне федеральне фінансування Міннесоти на час розслідування підозр у шахрайстві з програмою Paycheck Protection Program (PPP) на суму $430 мільйонів. Адміністратор SBA Келлі Леффлер повідомила губернатора Міннесоти Тіма Уолза про замороження понад $5,5 мільйона фінансування до подальшого розгляду. У листі вона зазначила, що особи, звинувачені в «сомалійській мережі шахрайства на мільярд доларів під час пандемії», отримали щонайменше $3 мільйони за кредитами PPP.Леффлер заявила, що «Міннесота не може бути довірена в адмініструванні федеральних податкових доларів», оскільки її «соціалістична система» дозволила шахрайство в промислових масштабах.

У мотелі Classic в Хіггінсвіллі (Міссурі) 23 грудня знайшли мертвою трирічну Новалей. Її біологічний батько, 33-річний Кайл Галлоуей, і його подруга, 36-річна Дін Хенкінс, звинувачені в смерті дитини після тривалих катувань.Дівчинка мала сліди від зав'язування пластиковими стяжками на зап'ястях і щиколотках, синці під очима, порізи на ногах і зап'ястях. За версією слідства, батько бив її по голові, а подруга била по голові та обличчю, обоє обзивали дитину образливими словами. За висунутими звинуваченнями Галлоуею і Хенкінс загрожує до 15 років в'язниці. Якщо прокурори перекваліфікують злочин в A felony, підозрюваним можуть дати довічне ув'язнення.

Китай розпочав 10-годинні навчання з бойовими стрільбами навколо Тайваню під назвою «Місія справедливості 2025». Ці маневри стали наймасштабнішими за охопленням території і найближчими до острова, включаючи п'ять зон навколо Тайваню.Навчання включають симуляцію блокади півночі і півдня острова, удари по морських і повітряних цілях, протичовнові операції, а також запуск 27 ракет у води Тайваню. У них задіяні 71 військовий літак Китаю, 24 кораблі ВМС і берегової охорони, а також нові десантні кораблі типу 075.Президент Тайваню Лай Чін-те заявив, що війська готові до оборони, але Тайбей не прагне до ескалації ситуації.

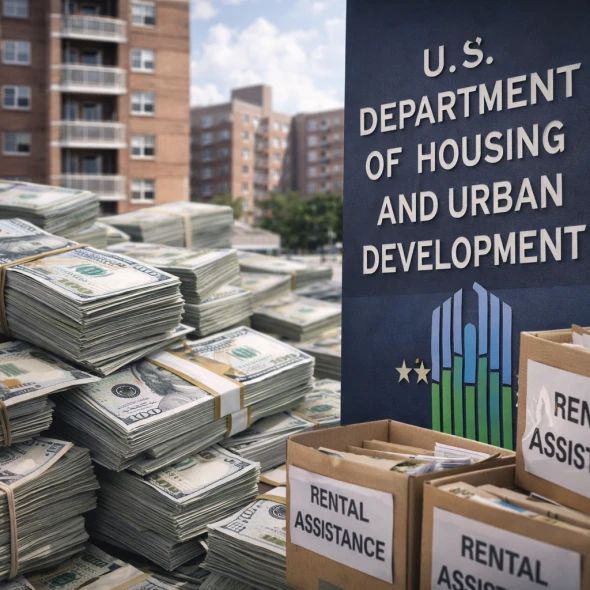

ВЗвіт Міністерства житлового будівництва та міського розвитку США (HUD) виявив понад $5,8 млрд потенційно неправомірних виплат за програмами допомоги з орендою житла у 2024 фінансовому році. Ці кошти виплатили приблизно 200 тисячам людей, які, ймовірно, не мали права на допомогу, що становить близько 11% від усіх бенефіціарів.Серед порушень - виплати 29 715 померлим орендарям і 9 472 негромадянам США. Крім того, 165 393 орендарі отримали суми, що перевищують регіональні ліміти допомоги, особливо в Новому Орлеані та інших великих містах.Міністр HUD Скотт Тернер заявив, що масове зловживання коштами платників податків сталося через слабкий контроль в адміністрації Байдена. Відомство має намір розслідувати випадки і притягнути винних до відповідальності, посилюючи заходи щодо захисту програм від шахрайства.

БУ 2015 році в Міннесоті батьки привозили дітей до дитячого садка, реєстрували їх, а потім відразу забирали назад. Це дозволяло центрам догляду за дітьми виставляти рахунки штату за повні дні догляду, хоча діти фактично не залишалися.Відео з камер спостереження, отримане журналістами, показує, як в деякі дні сім'ї взагалі не з'являлися, але дитячі садки все одно отримували державні виплати. Крім того, батькам, які брали участь у схемі, виплачувалися відкати, в одному з відео видно, як чоловік передає конверт з грошима.Ці кадри зі справи про шахрайство 2018 року пов'язані переважно з сомалійською громадою мігрантів у Міннеаполісі. Розслідування виявило схеми на мільйони доларів - частину більшого шахрайства на мільярд доларів.

Новини у твоєму месенджері

Дізнавайся першим!

Щоденне розсилання гарячих новин США та світу