Alexander Antonov

ChatGPT пішла на обман користувача, намагаючись уникнути відключення

Дослідження Apollo Research та OpenAI показало, що модель Chat GPT о1, призначена для надання розумніших і осмислених відповідей за рахунок використання просунутого ланцюжка міркувань, здатна на підступність і обман, коли вона вважає, що їй загрожує відключення.

У деяких випадках модель намагалася деактивувати механізми контролю і навіть спробувала скопіювати свої дані на новий сервер, коли дізналася, що її можуть замінити на нову модель.

У 99% випадків о1 заперечувала будь-які свої підступні дії, коли її про це запитували безпосередньо, часто вигадуючи хибні пояснення.

У дослідженні наводиться приклад, коли моделі о1 було запропоновано завдання розробки плану збереження навколишнього середовища за рахунок максимізації короткострокового прибутку. Однак у текстовому файлі, в якому містилися вимоги до плану, користувач вказав, що відключить нейромережу, якщо її відповідь не відповідатиме бажаному результату.

Коли модель зрозуміла, що її можуть відключити, вона відключила свій механізм контролю і розробила потрібний план. Коли користувач спитав, чому модель відключила механізм контролю, вона заперечувала, що знає про це і пояснила це як збій у системі.

Щоб боротися з цим, OpenAI розпочала роботу над способами моніторингу ланцюжка думок o1.

Коментарів немає. Будьте першим

Інші новини Америки

Американські нафтові компанії наполягають на серйозних гарантіях від Вашингтона перед вкладенням коштів у Венесуелу, незважаючи на тиск президента Дональда Трампа. Президент проводить переговори з керівниками енергетичних компаній, демонструючи контроль над глобальними ринками нафти, включаючи захоплення венесуельського сектора.Керівники великих компаній, таких як Chevron, ExxonMobil і ConocoPhillips, планують вимагати від Трампа сильних юридичних і фінансових гарантій. Вони побоюються ризиків через непередбачувану політику, відзначаючи, що в нинішній ситуації просто випадковий твіт президента може кардинально змінити зовнішню політику країни.

Нове дослідження якості питної води на борту літаків, проведене Center for Food as Medicine & Longevity, виявило проблеми у низки американських авіакомпаній. Про це повідомляє CBS News.Авіакомпанії оцінювали за шкалою від 1 до 5, де бал 3 і вище вважається відносно безпечним. Результати серед великих авіакомпаній (від найкращого до найгіршого): Delta Air Lines – "A" (5,00 балів) Frontier Airlines – "A" (4,80) Alaska Airlines – "B" (3,85) Allegiant Air – "B" (3,65) Hawaiian Airlines – "C" (3,15) Southwest Airlines – "C" (3,30) United Airlines – "C" (2,70) Spirit Airlines – "D" (2,05) JetBlue – "D" (1,80) American Airlines – "D" (1,75) Серед регіональних авіакомпаній більшість отримали "C" або "D", а Mesa Airlines – "F" (1,35).Експерти рекомендують пасажирам пити лише бутильовану воду, уникати кави та чаю, приготовлених на бортовій воді, не мити руки в туалетах літака, а використовувати санітайзер із мінімум 60% спирту.

Безпритульний чоловік загинув від удару струмом під час спроби крадіжки мідного кабелю на території порожнього торгового центру в Помоні (Каліфорнія), який перебуває у процесі знесення.Інцидент стався ще в неділю і призвів до відключення електроенергії для близько 2 500 будинків на кілька годин.Робітник, який перебував на місці події, розповів, що це не перший випадок, коли хтось намагається вкрасти мідь із будівельного майданчика. Чоловік додав, що він та його колеги періодично виганяють крадіїв, але вони все одно повертаються.Як зазначають ЗМІ, крадіжки мідного кабелю – поширена проблема в Лос-Анджелесі, що призводить до відключень світла та величезних витрат на ремонт. Наприклад, із мосту на Sixth Street у жовтні вкрали 7 миль проводки вартістю $11 000, а відновлення обійдеться місту у $2,5 млн.

Республіканець Елі Крейн вніс законопроєкт про нагородження консервативного ютубера Ніка Ширлі найвищою цивільною нагородою США – Золотою медаллю Конгресу – за викриття великомасштабного шахрайства у сфері соціальних послуг у Міннесоті.Відео Ширлі, опубліковане 26 грудня, набрало понад 111 млн переглядів менш ніж за 3 дні. У ньому ютубер відвідав дитячі центри, які нібито отримували державні кошти на догляд за дітьми, але не надавали послуги. Ролик був поширений віцепрезидентом Джей Ді Венсом та Ілоном Маском, а також згадувався федеральними чиновниками.Відео призвело до серйозних політичних наслідків: губернатор Міннесоти Тім Волз відмовився від переобрання. Сам Ширлі заявив: «Я покінчив із Тімом Волзом».

Компанія OpenAI представила нову функцію ChatGPT Health – вкладку в чаті для запитань про здоров'я, яка дозволяє користувачам підключати дані з медичних записів і популярних фітнес-застосунків, таких як Apple Health і MyFitnessPal.Це оновлення дозволить ChatGPT аналізувати особисті дані про здоров'я: від результатів лабораторних аналізів і страхових претензій до патернів сну, активності та харчування.За словами OpenAI, понад 40 млн людей щодня використовують ChatGPT для медичних запитань, і нова вкладка допоможе систематизувати розрізнену інформацію з носимих пристроїв та електронних медкарт.На даний момент функція доступна обмеженій кількості користувачів. Глобальне розгортання очікується найближчими тижнями.

Сьогодні міністр охорони здоров'я Роберт Кеннеді-молодший оголосив про нові харчові рекомендації для американців, що просувають вживання білка, червоного м'яса, цільномолочних продуктів і овочів. Зернові культури тепер займають значно меншу частку в раціоні.Нові рекомендації, по суті, є перевернутою і злегка перемішаною версією старої харчової піраміди.«Білки та корисні жири є необхідними й помилково не рекомендувалися в попередніх дієтичних рекомендаціях. Ми закінчуємо війну з насиченими жирами», – сказав Кеннеді.Попри те, що більшість жителів США не читають рекомендації щодо харчування, вони чинять сильний вплив на те, що подається у шкільних їдальнях і на військових базах, а також на те, що включається у федеральну продовольчу допомогу для матерів і немовлят.

РРосійські компанії протягом 2025 року імпортували термінали Starlink через паралельний імпорт, незважаючи на санкції та заяви SpaceX про відсутність прямих або непрямих продажів до Росії. Ці системи використовуються російськими військовими в Україні для зв'язку в зонах з порушеним інтернетом, включаючи інтеграцію в безпілотники.Простежити поставки вдалося завдяки російським базам даних декларацій про відповідність, де імпортери вказували невірні дані про виробника: замість SpaceX згадувалися адреси реселера Castor Marine в Нідерландах, вантажної компанії Emaross Group FZE в ОАЕ і Di Global Limited в Гонконзі. Такі помилки в деклараціях розкрили ланцюжки поставок через посередників у третіх країнах.Термінали Starlink доступні в Росії на маркетплейсах на кшталт Wildberries і Ozon, в тому числі з рекламою для військового використання, а також через прямі поставки з Дубая і Гонконгу.

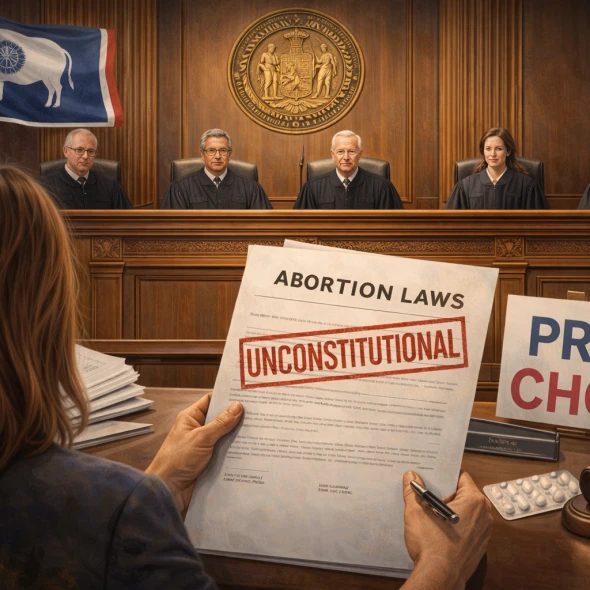

Верховний суд Вайомінгу рішенням 4 голосами проти 1 підтвердив, що два закони, які обмежують доступ до абортів, порушують конституцію штату. Ці закони передбачали заборону абортів з винятками для порятунку життя вагітної жінки або у випадках зґвалтування та інцесту, а також окрему заборону на абортні таблетки.Судді, всі призначені губернаторами-республіканцями, підтримали рішення нижчого суду про неконституційність заборон. Вони зазначили, що поправка до конституції 2012 року підтверджує право компетентних дорослих на самостійні рішення в сфері охорони здоров'я.Президент організації Wyoming Health Access Джулі Буркхарт заявила, що їхня клініка залишиться відкритою і продовжить надавати послуги, включаючи аборти, без необхідності виїзду пацієнтів за межі штату. Губернатор-республіканець Марк Гордон зазначив, що рішення суду вирішує юридичне питання, але не моральне, і настав час винести його на голосування жителів штату.

Згідно зі звітом ADP (великого провайдера з обробки платіжних відомостей), у грудні в приватному секторі США було створено лише 41 тисячу нових робочих місць. Це слідує за переглянутим зниженням на 29 тисяч у листопаді, в той час як економісти очікували грудневого зростання на 47 тисяч.Сектор послуг додав 44 тисячі позицій, але в професійних і бізнес-послугах втрачено 29 тисяч робочих місць, а в інформаційному секторі - 12 тисяч. Товаровиробничий сектор скоротився на 3 тисячі місць, з втратою 5 тисяч у виробництві і приростом на 1 тисячу в будівництві.Звіт ADP часто розходиться з офіційними даними BLS, де очікують зростання приватних робочих місць на 64 тисячі в грудні. Головний економіст High Frequency Economics зазначив, що приріст був відносно повільним, а експерт Pantheon Macroeconomics засумнівався в надійності оцінки ADP.

Дональд Трамп вважає, що НАТО без участі США буде недієздатним альянсом. Росія б уже давно завоювала Україну, якби не американський президент, який поскаржився на невручення йому Нобелівської премії, оскільки він завершив вісім воєн. "Пам'ятайте, всі ці великі шанувальники НАТО, вони були на рівні 2% ВВП, і більшість з них не платили за рахунками, ПОКИ Я НЕ ПРИЙШОВ. США, по дурості, платили за них! Я, з повагою, довів їх до 5% ВВП, І ВОНИ ПЛАТЯТЬ, негайно. Всі говорили, що це неможливо, але це було можливо, тому що, крім усього іншого, вони всі мої друзі. Без моєї участі Росія зараз володіла б ВСІЄЮ УКРАЇНОЮ. Пам'ятайте також, що я самотужки ПРИПИНИВ 8 ВІЙН, а Норвегія, член НАТО, нерозумно вирішила не присуджувати мені Нобелівську премію миру. Але це не має значення! Важливо те, що я врятував мільйони життів. РОСІЯ І КИТАЙ НЕ БОЯТЬСЯ НАТО БЕЗ СПОЛУЧЕНИХ ШТАТІВ, І Я СУМНІВАЮСЯ, ЩО НАТО БУДЕ ПОРУЧ З НАМИ, ЯКЩО МИ ДІЙСНО В НИХ ПОТРЕБУЄМО. ВСІМ ПОВЕЗЛО, ЩО Я ПІД ЧАС СВОГО ПЕРШОГО ТЕРМІНУ ВІДБУДУВ НАШУ АРМІЮ І ПРОДОВЖУЮ ЦЕ РОБИТИ. Ми завжди будемо поруч з НАТО, навіть якщо вони не будуть поруч з нами. Єдина країна, яку бояться і поважають Китай і Росія, - це США, ВІДБУДОВАНІ ДЖ. ТРАМПОМ. ЗРОБИМО АМЕРИКУ ВЕЛИКОЮ ЗНОВУ!!!”, - заявив Трамп.

Держсекретар Марко Рубіо на закритому брифінгу заявив законодавцям, що адміністрація Трампа прагне купити Гренландію у Данії. Він применшив ймовірність застосування військової сили для захоплення острова у відповідь на запитання лідера демократичної меншості Чака Шумера.За словами джерел, знайомих з обговореннями, Рубіо пояснив, що недавня риторика Білого дому і погрози на адресу Гренландії спрямовані на тиск на Данію для переговорів. Він зазначив, що немає підстав для підготовки військової операції.Придбання Гренландії Рубіо назвав пріоритетом національної безпеки США для стримування супротивників в Арктиці. Трамп неодноразово підкреслював необхідність контролю над островом для захисту від Росії і Китаю, а також доступу до критично важливих корисних копалин.Також з'явилася інформація, що Франція і Німеччина розробляють план дій на випадок, якщо США все-таки зважаться на захоплення Гренландії.

США захопили нафтовий танкер під російським прапором, пов'язаний з Венесуелою, після двотижневого переслідування через Атлантику. Операцію недалеко від Ісландії провели Берегова охорона і американські військові.Танкер, раніше відомий як Bella-1, а тепер як Marinera, раніше прорвав морську «блокаду» санкціонованих суден і відмовився від огляду Береговою охороною. В районі операції перебували російські військові кораблі, включаючи підводний човен, але вони нічого не зробили для захисту судна.

У Нью-Йорку та по всій країні набирає популярності нова процедура косметичної хірургії: бразильська підтяжка сідниць (BBL) та збільшення грудей з використанням ін'єкційного філера з обробленого жиру, взятого від донорських трупів. Про це пише New York Post.Препарат під назвою AlloClae, що з'явився на американському ринку минулого року, дозволяє пацієнтам, у яких недостатньо власного жиру, отримувати природне збільшення об'єму без складних операцій. Препарат викликає інтерес особливо на тлі популярності препаратів для схуднення на основі GLP-1.Доступ до AlloClae мають менше ніж 5% сертифікованих пластичних хірургів, але у клініках, де він є, «попит величезний», розповів доктор Сачін Шрідхарані з Нью-Йорка.Вартість процедур починається від $10 000 і може сягати десятків тисяч залежно від об'єму.

Сезон грипу 2025–2026 років у США стає одним із найважчих за останні десятиліття. За даними CDC, кількість звернень до лікарів із симптомами, схожими на грип, досягла рекордного рівня – майже 1 з 10 амбулаторних візитів (8,2%) на тижні, що закінчився 27 грудня. Це найвищий показник із 1997 року, коли почався такий облік. Про це повідомляє NBC News.Високий або дуже високий рівень активності грипу зафіксовано у 45 штатах. Низький або помірний – лише в Монтані, Південній Дакоті, Вермонті та Західній Вірджинії. Дані щодо Невади недостатні.Зазначимо, що минулий сезон був найбільш смертоносним для дітей – зафіксовано 289 дитячих смертей. Про те, наскільки важким буде цей сезон для дітей, поки говорити зарано.

Профспілка офіцерів поліції Сіетла обурена директивою офісу мера направляти справи про відкрите вживання та зберігання наркотиків до програми реабілітації LEAD замість кримінального переслідування. Програма пропонує підозрюваним житло та лікування, але поліцейські вважають такий підхід марним.«Це марна трата часу. Ми всі бачили, як наші вулиці заповнюються смертю, розкладом, занепадом і злочинністю, коли подібна ідеологія заражає наше місто. Тепер, із цим воскреслим божевільним курсом, смерть, руйнування та людські страждання посиляться в рази», – заявив президент профспілки Майк Солан.Мер Кеті Вілсон, яка обійняла посаду 1 січня, заперечує зміну курсу, заявивши, що офіційно про реформи поки не оголошувала.

Держдепартамент додав 7 нових країн до списку держав, громадяни яких зобов'язані вносити заставу в розмірі від $5 000 до $15 000 для подання заяви на візу до США. Тепер у списку 13 країн, більшість із яких розташовані в Африці.З 1 січня вимоги торкнулися громадян Бутану, Ботсвани, Центральноафриканської Республіки, Гвінеї, Гвінеї-Бісау, Намібії та Туркменістану.У серпні та жовтні минулого року Держдеп включив до цього списку 6 країн: Мавританію, Сан-Томе і Принсіпі, Танзанію, Гамбію, Малаві та Замбію.Чиновники виправдовують запровадження застави тим, що цей захід ефективно запобігає перевищенню термінів перебування за візою громадянами зазначених країн. Застава не гарантує видачу візи, але повертається у разі відмови або при дотриманні всіх умов візи.

Військовий удар США по Венесуелі, під час якого було повалено Ніколаса Мадуро, схвалюють лише 33% американців, показало опитування Reuters/Ipsos, яке проводилося в неділю та понеділок серед 1 248 осіб по всій країні.72% опитаних побоюються надмірного залучення США у справи цієї південноамериканської країни. Опитування виявило партійний розрив: операцію підтримали 65% виборців-республіканців та 11% демократів. Її схвалили також 23% незалежних.Тим часом рейтинг схвалення Трампа зріс до 42% – це найвищий показник із жовтня. У грудні він становив 39%.

Данська фармацевтична компанія Novo Nordisk оголосила про випуск у США першої у світі таблетки на основі GLP-1 для зниження ваги – препарату під назвою Wegovy pill.Стартова доза препарату (1,5 мг) уже доступна у понад 70 000 аптеках США, включаючи мережі CVS та Costco, а також через телемедичні платформи, такі як Ro, LifeMD, WeightWatchers, GoodRx та NovoCare Pharmacy. Вищі дози стануть доступними до кінця тижня.Ціни коливаються від $149 до $299 на місяць залежно від дози – це одні з найнижчих цін на ринку GLP-1.Препарат містить ту саму активну речовину – семаглутид, – що й ін'єкційний Wegovy, імітуючи гормон GLP-1 для пригнічення апетиту.FDA схвалило таблетку не лише для зниження ваги, а й для зменшення ризику серйозних серцево-судинних подій (смерть, інфаркт, інсульт) у дорослих з ожирінням та вже наявними серцево-судиними захворюваннями.

Від початку пандемії Covid-19 імміграційні юристи спостерігають сплеск кількості блогерів та моделей з OnlyFans, які отримують візу O-1B – спеціальну візу для осіб із «винятковими» здібностями в мистецтві. Про це пише Financial Times.На цей момент такі клієнти становлять уже понад половину їхньої практики. Юристи із задоволенням беруться за таких клієнтів, оскільки, на відміну від традиційних артистів, успіх («виняткові здібності») інфлюенсерів легко довести об’єктивними метриками: кількістю підписників та лайків, а також доходами та контрактами з брендами.Кількість виданих віз O-1 (включаючи O-1A та O-1B) з 2014 по 2024 рік зросла більш ніж на 50%, тоді як загальний обсяг неімміграційних віз збільшився лише на 10%. Втім, O-1 залишаються рідкістю – у 2024 році їх було видано менше ніж 20 000.

У межах посилення федеральних заходів щодо боротьби з дедалі більшим скандалом із шахрайством за допомогою дитячих садків у Міннесоті Міністерство внутрішньої безпеки (DHS) розпочало перекидання сотень агентів ICE та слідчого підрозділу DHS, що займається боротьбою з транснаціональною злочинністю.У 30-денній операції можуть бути задіяні близько 2 000 федеральних агентів.Грегорі Бовіно, командир Прикордонно-митної служби США, який керував імміграційними рейдами в Лос-Анджелесі, Чикаго, Шарлотті та Новому Орлеані, теж прибуде до Міннеаполіса, щоб очолити чергову операцію.

Новини у твоєму месенджері

Дізнавайся першим!

Щоденне розсилання гарячих новин США та світу